آبل تطور ذكاءً اصطناعياً يحول الفيديو الصامت إلى صوت

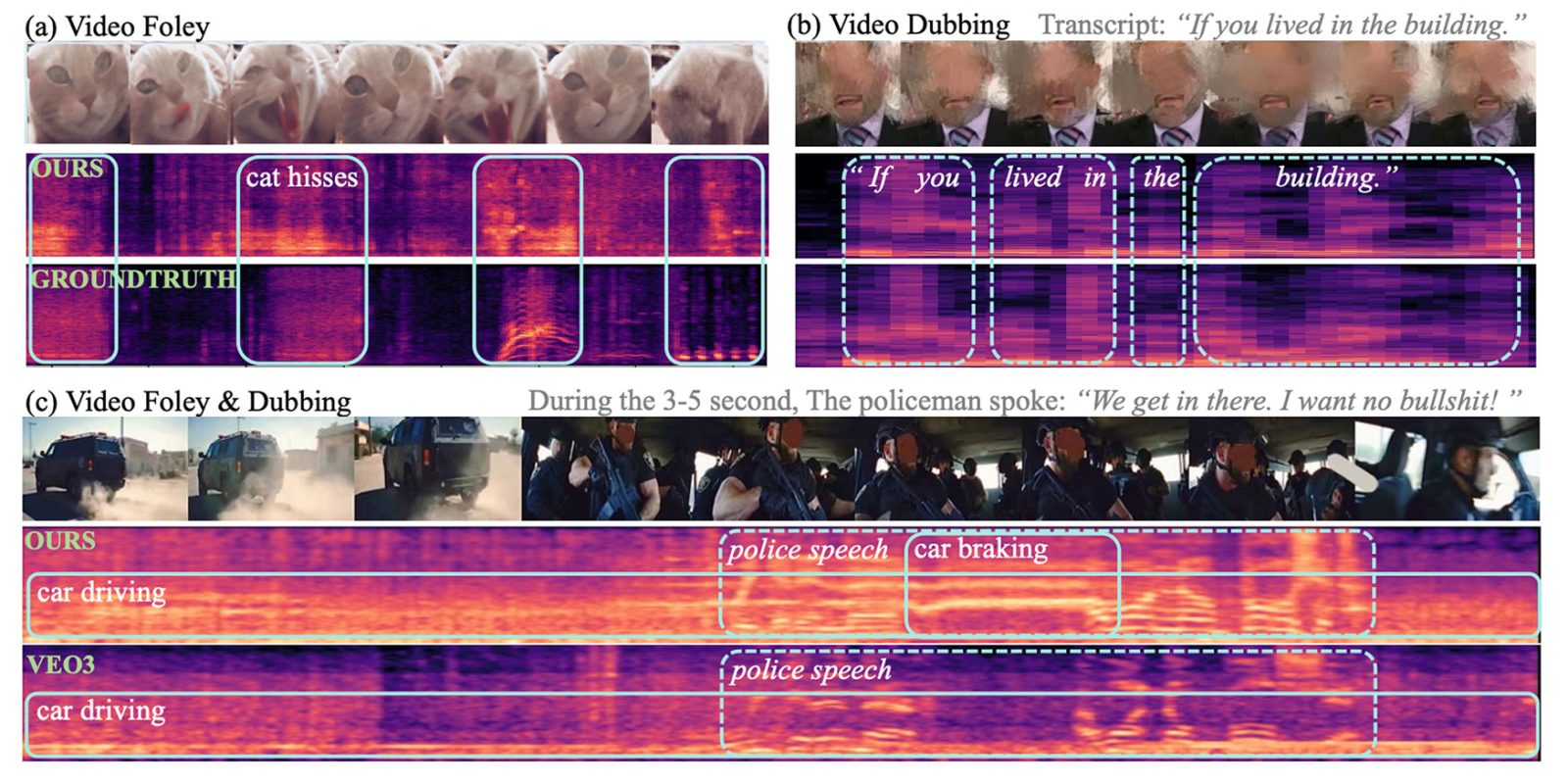

طور باحثون من شركة آبل بالتعاون مع جامعة رينمين الصينية نموذج ذكاء اصطناعي جديد يُدعى "VSSFlow"، قادر على توليد الكلام والمؤثرات الصوتية من الفيديو الصامت بدقة مذهلة عبر نظام موحد.

المشكلة في النماذج الحالية

تواجه معظم نماذج تحويل الفيديو إلى صوت (V2S) الحالية صعوبة في توليد كلام بشري دقيق، وبالمثل، تفشل نماذج تحويل النص إلى كلام (TTS) في إنتاج مؤثرات صوتية بيئية مقنعة لأنها مصممة لغرض مختلف.

علاوة على ذلك، كانت المحاولات السابقة لتوحيد المهمتين مبنية غالباً على افتراض أن التدريب المشترك يقلل من الأداء، مما أدى إلى أنظمة معقدة تفصل بين تعليم الكلام والمؤثرات الصوتية في مراحل مختلفة.

حل مبتكر وبنية موحدة

قام ثلاثة باحثين من آبل وستة من جامعة رينمين بتطوير VSSFlow لتغيير هذا المفهوم. يعتمد النموذج على بنية معمارية مكونة من 10 طبقات تدمج إشارات الفيديو والنصوص مباشرة في عملية توليد الصوت.

يستخدم النموذج تقنيات الذكاء الاصطناعي التوليدي، بما في ذلك تحويل النصوص إلى تسلسلات صوتية (phonemes) واستخدام تقنية "مطابقة التدفق" (flow-matching) لإعادة بناء الصوت من الضوضاء العشوائية بكفاءة.

كيف يعمل النموذج؟

لتوليد الصوت والكلام من فيديو صامت، يبدأ النموذج من ضوضاء عشوائية ويستخدم إشارات بصرية من الفيديو بمعدل 10 إطارات في الثانية لتشكيل الأصوات المحيطة. في الوقت نفسه، يوفر نص الكلام (Transcript) توجيهاً دقيقاً للصوت المنطوق.

وقد لاحظ الباحثون أن التدريب المشترك على الكلام والصوت أدى في الواقع إلى تحسين الأداء في كلتا المهمتين بدلاً من التسبب في تضارب، حيث يعزز كل منهما الآخر.

نتائج واعدة ومفتوحة المصدر

عند اختباره مقابل نماذج متخصصة، قدم VSSFlow نتائج تنافسية وتفوق في عدة مقاييس رئيسية. ولتحقيق القدرة على توليد الخلفية الصوتية والحوار معاً، قام الفريق بضبط النموذج بدقة على مجموعة كبيرة من الأمثلة الاصطناعية المختلطة.

الجدير بالذكر أن الباحثين قاموا بنشر كود VSSFlow كمصدر مفتوح على منصة GitHub، وهم يعملون حالياً على إتاحة أوزان النموذج (Model Weights) وتوفير نسخة تجريبية للاستخدام.

مستقبل التوليد الصوتي

أشار الباحثون إلى أن هذا العمل يؤسس لنموذج جديد في توليد الصوت والكلام المشروط بالفيديو. ومع ذلك، لا تزال هناك تحديات مستقبلية، أبرزها ندرة بيانات الفيديو والصوت والكلام عالية الجودة، والحاجة إلى تطوير طرق تمثيل أفضل تحافظ على تفاصيل الكلام مع الحفاظ على أبعاد مدمجة.

الأسئلة الشائعة

هو نموذج ذكاء اصطناعي طوره باحثون من آبل وجامعة رينمين لتوليد المؤثرات الصوتية والكلام البشري من مقاطع الفيديو الصامتة في نظام موحد.

يتميز بدمج تدريب الصوت والكلام معاً في عملية واحدة، مما يحسن الأداء في كلتا المهمتين، عكس النماذج السابقة التي كانت تفصل بينهما.

نعم، قام الباحثون بنشر الكود المصدري للنموذج على منصة GitHub، ويعملون على إتاحة أوزان النموذج قريباً.

التعليقات 0

سجل دخولك لإضافة تعليق

لا توجد تعليقات بعد. كن أول من يعلق!